1、MapReduce和Sparkmapreduce与spark的区别的主要区别在于数据处理方式和速度Spark使用内存计算mapreduce与spark的区别,而MapReduce使用硬盘计算mapreduce与spark的区别,因此Spark在处理大数据时通常更快1 数据处理方式 MapReduce和Spark都是大数据处理技术mapreduce与spark的区别,但它们的处理方式存在显著的差异MapReduce是一个批处理系统,它处理数据的方式是通过将大数据集分割成小数据集,然后。

2、而Spark则是一个通用的集群计算框架,它不仅支持MapReduce的处理方式,还提供了更广泛的数据处理功能Spark的核心概念是弹性分布式数据集RDD,它能够在内存中缓存数据,使得迭代算法和实时数据处理变得更加高效Spark不仅能够用于批处理,还可以用于流处理和交互式查询,具有很高的灵活性和性能YARNYet。

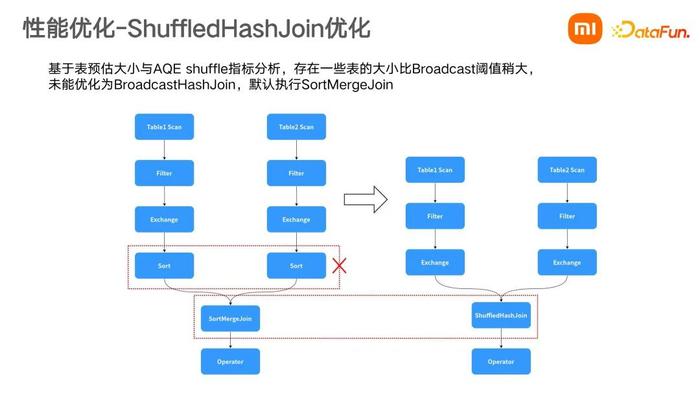

3、Spark和MapReduce在计算过程中通常都不可避免的会进行Shuffle,两者至少有一点不同MapReduce在Shuffle时需要花费大量时间进行排序,排序在MapReduce的Shuffle中似乎是不可避免的Spark在Shuffle时则只有部分场景才需要排序,支持基于Hash的分布式聚合,更加省时3多进程模型 vs 多线程模型的区别 这俩根本。

4、Spark和MapReduce相比,都有哪些优势一个最明显的优点就是性能的大规模提升通俗一点说,mapreduce与spark的区别我们可以将MapReduce理解为手工作坊式生产,每一个任务都是由作坊独立完成涉及到大规模的生产时,由于每一个作坊都要独立处理原料采购制作存储运输等等环节,需要花费大量的人力计算资源物力能源消耗。

5、其实 Spark 和 Hadoop MapReduce 的重点应用场合有所不同相对于 Hadoop MapReduce 来说,Spark 有点“青出于蓝”的感觉,Spark 是在Hadoop MapReduce 模型上发展起来的,在它的身上我们能明显看到 MapReduce的影子,所有的 Spark 并非从头创新,而是站在了巨人“MapReduce”的肩膀上千秋功罪,留于。

6、MapReduce任务包含Map和Reduce阶段,数据处理完成后,结果写入磁盘,适用于大规模离线计算,但读写数据频繁,耗时且效率低下Spark框架改进了MapReduce模式,提供内存计算模型,支持数据高速缓存和重复使用,加速计算效率Spark采用基于DAG的执行引擎,自动优化计算流程,提高性能Spark任务包含多个Map和Reduce。

7、Hadoop和Spark的异同 差异1 数据处理方式 Hadoop主要基于批处理,处理大规模数据集,适用于离线数据分析Spark则支持批处理流处理和图计算,处理速度更快,适用于实时数据分析2 运行模型 Hadoop依赖集群进行分布式计算,其核心是MapReduce模型而Spark支持多种编程范式,如RDDDataFrame和SQL等。

8、1 分布式存储 Hadoop 分布式文件系统 HDFS一种可扩展的分布式文件系统,用于存储海量数据HBase一种基于 Hadoop 的数据库,用于存储分布式结构化的数据Cassandra一种无模式的分布式数据库,用于存储键值对数据2 分布式计算 MapReduce一种编程模型,用于并行处理大规模数据集Spark一种。

9、Spark 是专为大规模数据处理而设计的快速通用的计算引擎是Hadoop MapReduce的通用并行框架,Spark,拥有Hadoop MapReduce所具有的优点但不同于MapReduce的是Job中间输出结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的MapReduce的算法1RDD。

10、请看下面这张图狭义的Hadoop 也就是最初的版本只有HDFS Map Reduce 后续出现很多存储,计算,管理 框架如果说比较的话就 Hadoop Map Reduce 和 Spark 比较,因为他们都是大数据分析的计算框架Spark 有很多行组件,功能更强大,速度更快1解决问题的层面不一样 首先,Hadoop和Apache Spark两者。

11、Apache Spark是一个高效集群计算平台,专为速度与通用性设计它继承了MapReduce模型的优势,并进一步优化了对于交互式查询迭代算法流处理等计算类型的支持,特别在大数据处理速度方面,Spark能够显著提升效率,相较于MapReduce可达到1020倍的速度提升Spark的核心组件包括任务调度内存管理容错恢复及。

12、Hadoop与Spark都是用于大数据处理的框架,它们在解决问题的层面和优势上存在差异Hadoop的主旨在分布式存储与处理大量数据,通过MapReduce模型将大数据分解并行处理后重新组合,实现数据的存储与计算然而,MapReduce在数据处理速度和复杂性处理上存在局限性,尤其是在处理实时数据或需要频繁迭代计算任务时效率。

13、尽管Spark可以独立运行,但许多人倾向于将它们结合使用,因为这种组合被普遍认为是最优选择以下是关于MapReduce的简洁解析将人理解成计算机,MapReduce将任务分配给每个计算机节点,然后收集每个节点的结果,最后汇总所有结果,以完成整个任务两者在技术实现上也有差异Hadoop采用批处理模型,而Spark则。

14、其实很早之前就想对spark做一下自己的阐述,一直也无奈于不能系统的进行以下自己的解释,现在还是想粗略的说一下我自己对spark的一些认识 spark相对于mapreduce来说,计算模型可以提供更强大的功能,他使用的是迭代模型,我们在处理完一个阶段以后,可以继续往下处理很多个阶段,而不只是像mapreduce一样只有两个阶段 spa。

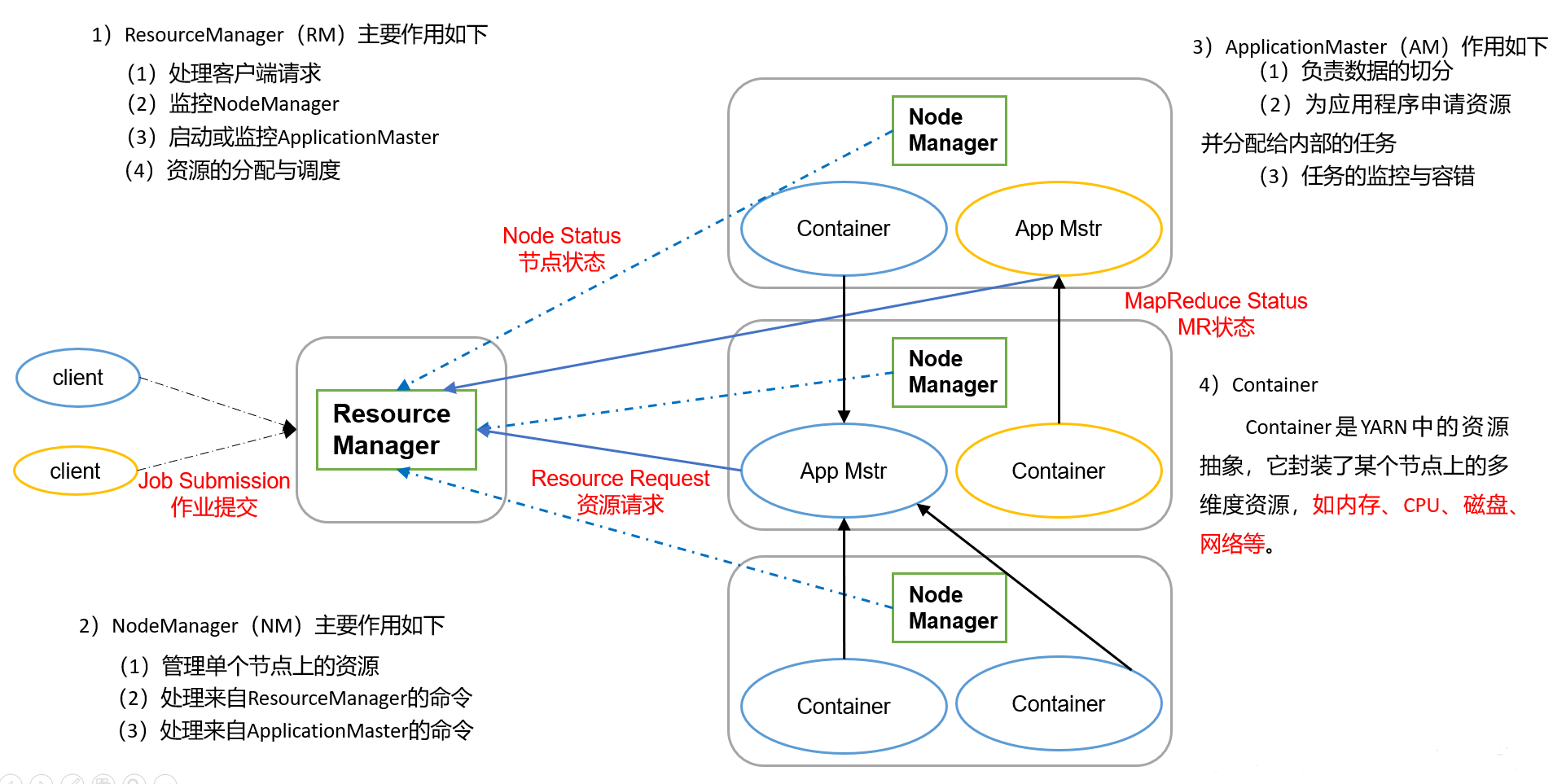

15、将spark运行在资源管理系统上将带来非常多的收益,包括与其他计算框架共享集群资源资源按需分配,进而提高集群资源利用率等FrameWork On YARN 运行在YARN上的框架,包括MapReduceOnYARN, SparkOnYARN, StormOnYARN和TezOnYARN1MapReduceOnYARNYARN上的离线计算2SparkOn。

本文仅代表作者观点,不代表百度立场。

本文系作者授权百度百家发表,未经许可,不得转载。

发表评论